Машинное обучение

Искусственный интеллект (AI) и глубокое обучение (DL) позволяют предприятиям бороться с мошенничеством, улучшать взаимоотношения с заказчиками, оптимизировать цепочки поставок и развивать инновационные продукты и сервисы на высококонкурентном рынке.

Упроcтите и ускорьте и интеграцию процесса обработки данных для глубокого обучения и AI с решением FORSITE ONTAP.

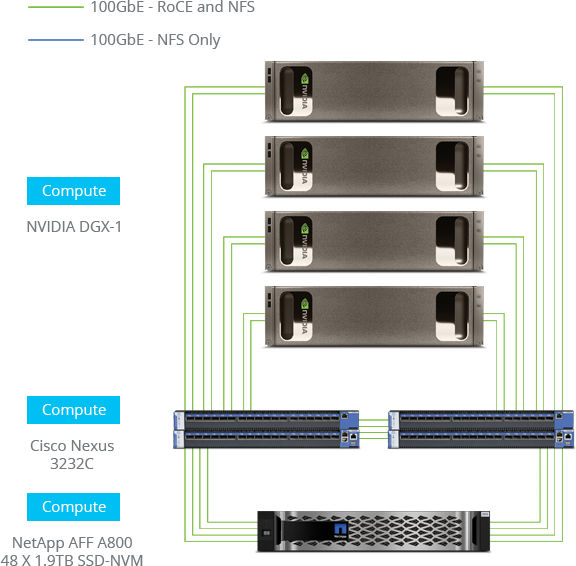

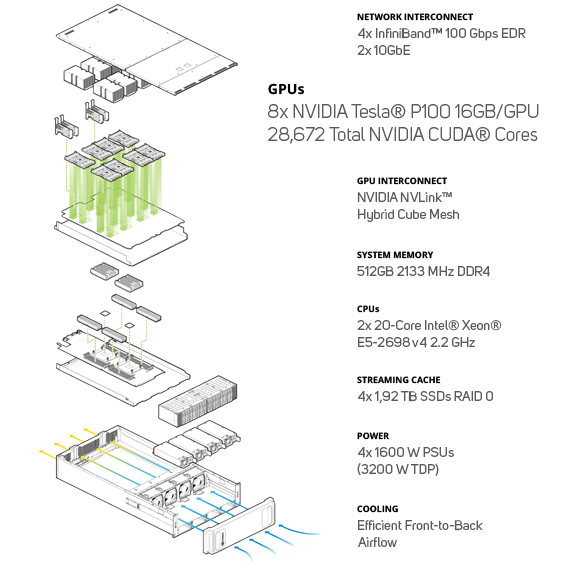

FORSITE ONTAP - это возможность полностью реализовать возможности AI и DL, упростив, ускорив и интегрировав потоки обработки данных в архитектуре совместного эталонного решения ONTAP AI, разработанного совместно NetApp и NVIDIA, и включающего в себя суперкомпьютеры NVIDIA DGX, высокоскоростные коммутаторы и All Flash СХД NetApp A800 с NVMe архитектурой. ONTAP AI позволяет поставить на поток надежную и быструю подачу данных для обучения моделей и процессов распознавания образов.

FORSITE ONTAP – это референсная архитектура, основанная на NVIDIA DGX POD™, которая объединяет в себе лучшие решения для вычислений, сетей, хранения и охлаждения. Архитектура имеет конвергентный инфраструктурный дизайн на основе систем NVIDIA DGX-1 и DGX-2.

Тестирование ONTAP AI при помощи данных ImageNet при сочетании 4х серверов NVIDIA DGX-1 и 1 СХД NetApp A800, показало обучающую пропускную способность 23000 изображения в секунду (training images per second - TIPS) и распознавательную пропускную способность 60000 TIPS. С этой конфигурацией можно ожидать более 2ГБ/сек установившейся полосы пропускания (до 5ГБ/сек в пиках) при времени отклика СХД заведомо ниже 1 мсек и утилизации GPU более 95%.

Одна система A800 поддерживает пропускную способность более 25ГБ/с на последовательном чтении и более 1 миллиона IOPS на случайном чтении при времени отклика менее 500 мкс на файловых нагрузках (NAS). Эти результаты показывают доступную производительность, которая может снабдить потоком данных намного больше серверов DGX-1 по мере роста требований.

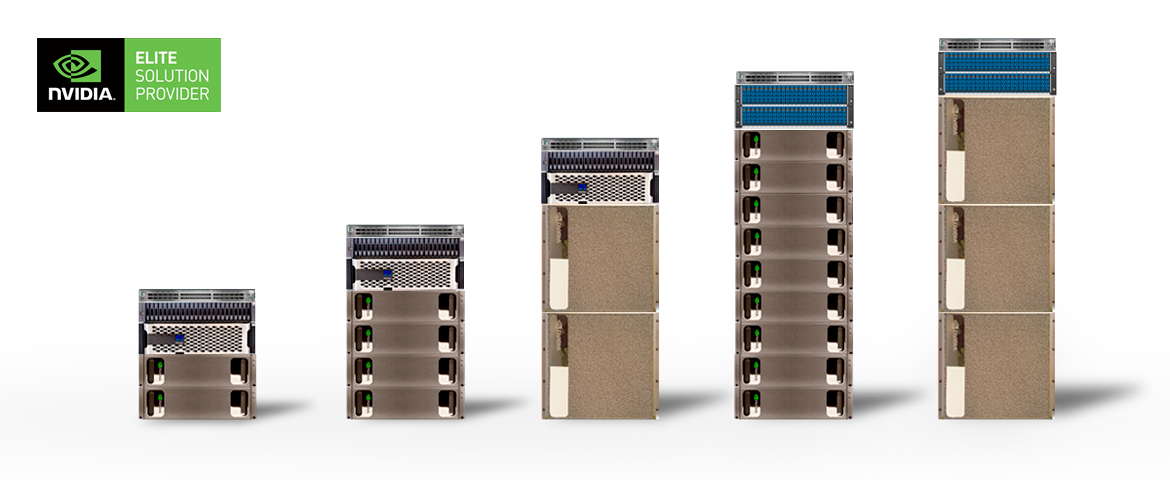

ONTAP AI позволяет начинать с малого и расти по мере необходимости. Вы можете добавлять вычислительную, сетевую составляющие, а также новую емкость без остановки текущих операций. Начав с соотношения серверов к СХД 1:1, можно нарастить количество серверов до 5 и более. Архитектура NetApp позволяет начинать с небольших СХД A220 и наращивать их с сотен ТБ до Петабайт флэш емкости. Благодаря технологии ONTAP FlexGroup, емкость может быть увеличена до 20ПБ в едином пространстве имен, которое может справляться с более чем 400 млрд. файлов.

ONTAP AI использует концепцию NetApp Data Fabric, чтобы объединить процесс управления данными на всем протяжении их жизненного цикла. Вы можете использовать единый набор инструментов для их безопасного контроля и защиты, не нарушая при этом регулирующих требований. Если возникает проблема в окружении с нейронными сетями, то вы всегда сможете положиться на нашу проверенную модель поддержки с единым окном контакта, необходимой для решения проблем.