Суперкомпьютеры и GPU-вычисления.

Онлайн-конфигуратор суперкомпьютеров и GPU серверов.

Вычисления на GPU

Вычисления с GPU-ускорением предлагают беспрецедентную производительность приложений благодаря тому, что GPU обрабатывает части приложения, требующие большой вычислительной мощности, при этом остальная часть приложения выполняется на CPU. С точки зрения пользователя, приложение просто работает значительно быстрее.

Простой способ понять разницу между CPU и GPU – это сравнить то, как они выполняют задачи. CPU состоит из нескольких ядер, оптимизированных для последовательной обработки данных, в то время как GPU состоит из тысяч более мелких и энергоэффективных ядер, созданных для обработки нескольких задач одновременно.

Вычисления HPC – фундаментальная опора современной науки. Начиная от прогнозирования погоды и создания новых лекарств и заканчивая поиском источников энергии, ученые постоянно используют большие вычислительные системы для моделирования нашего мира и прогнозирования событий в нем. Искусственный интеллект расширяет возможности HPC, позволяя ученым анализировать большие объемы данных и добывая полезную информацию там, где одни симуляции не могут предоставить полную картину происходящего.

Графический ускоритель NVIDIA A100 и H100 создан, чтобы обеспечить слияние HPC и искусственного интеллекта. Это решение для HPC-систем, которое отлично проявит себя как в вычислениях для проведения симуляций, так и обработке данных для извлечения из них полезной информации.

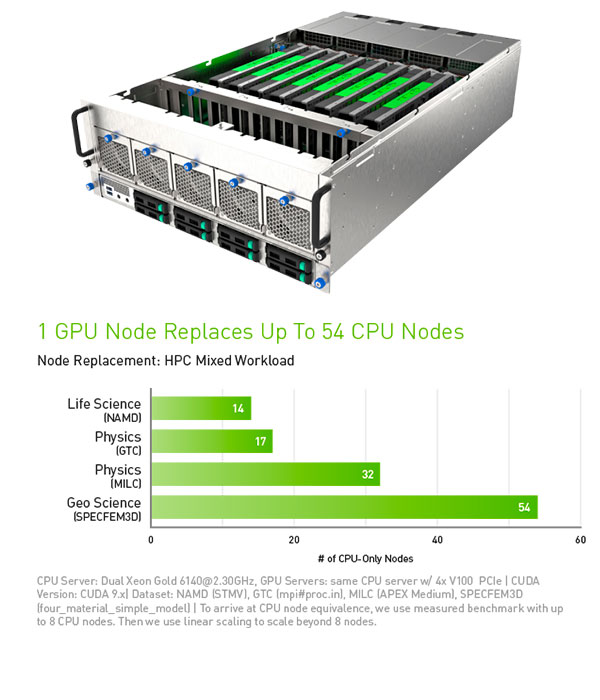

Благодаря объединению в одной архитектуре ядер CUDA и Tensor, сервер, оснащенный графическими ускорителями NVIDIA A100 и H100, может заменить сотни традиционных CPU-серверов, выполняя традиционные задачи HPC и искусственного интеллекта. Теперь каждый ученый может позволить себе суперкомпьютер, который поможет в решении самых сложных проблем.

ВЫСОЧАЙШАЯ ПРОИЗВОДИТЕЛЬНОСТЬ

![Turing-Tensor-Core_30fps_FINAL_736x414[1].gif Turing-Tensor-Core_30fps_FINAL_736x414[1].gif](/upload/medialibrary/29e/29e84edaec3e44e8c8f3b058ab2d44dd.gif)

Производительность приложений - это не просто флопы. Профессионалы в области вычислений полагаются на серьезные приложения для значительного ускорения научных открытий и анализа данных. Их работа начинается с самых быстрых в мире ускорителей и включает в себя надежную инфраструктуру, возможность контролировать и управлять этой инфраструктурой, а также возможность быстро перенаправлять данные, когда это необходимо. Вычислительная платформа, ускоряемая на графических решениях NVIDIA A100 и H100, предоставляет все выше указанное для обеспечения непревзойденной производительности приложений в сфере науки, аналитики, инжиниринга, а также в пользовательских и корпоративных приложениях.

Графические процессоры NVIDIA H100, оснащенные тензорными ядрами четвертого поколения и Transformer Engine с точностью FP8, ускоряют обучение до 9 раз по сравнению с предыдущим поколением для моделей коллектива экспертов (MoE). Сочетание NVlink четвертого поколения, обеспечивающее соединение между графическими процессорами со скоростью 900 гигабайт в секунду (ГБ/с), системы NVSwitch, ускоряющей коллективную связь каждого GPU между узлами, PCIe 5-го поколения и ПО NVIDIA Magnum IO™ обеспечивает эффективную масштабируемость как для небольших предприятий, так и для крупных унифицированных кластеров GPU.

УСКОРЬТЕ РЕШЕНИЕ ЗАДАЧ С ПОМОЩЬЮ РЕШЕНИЙ ДЛЯ ДАТА-ЦЕНТРОВ

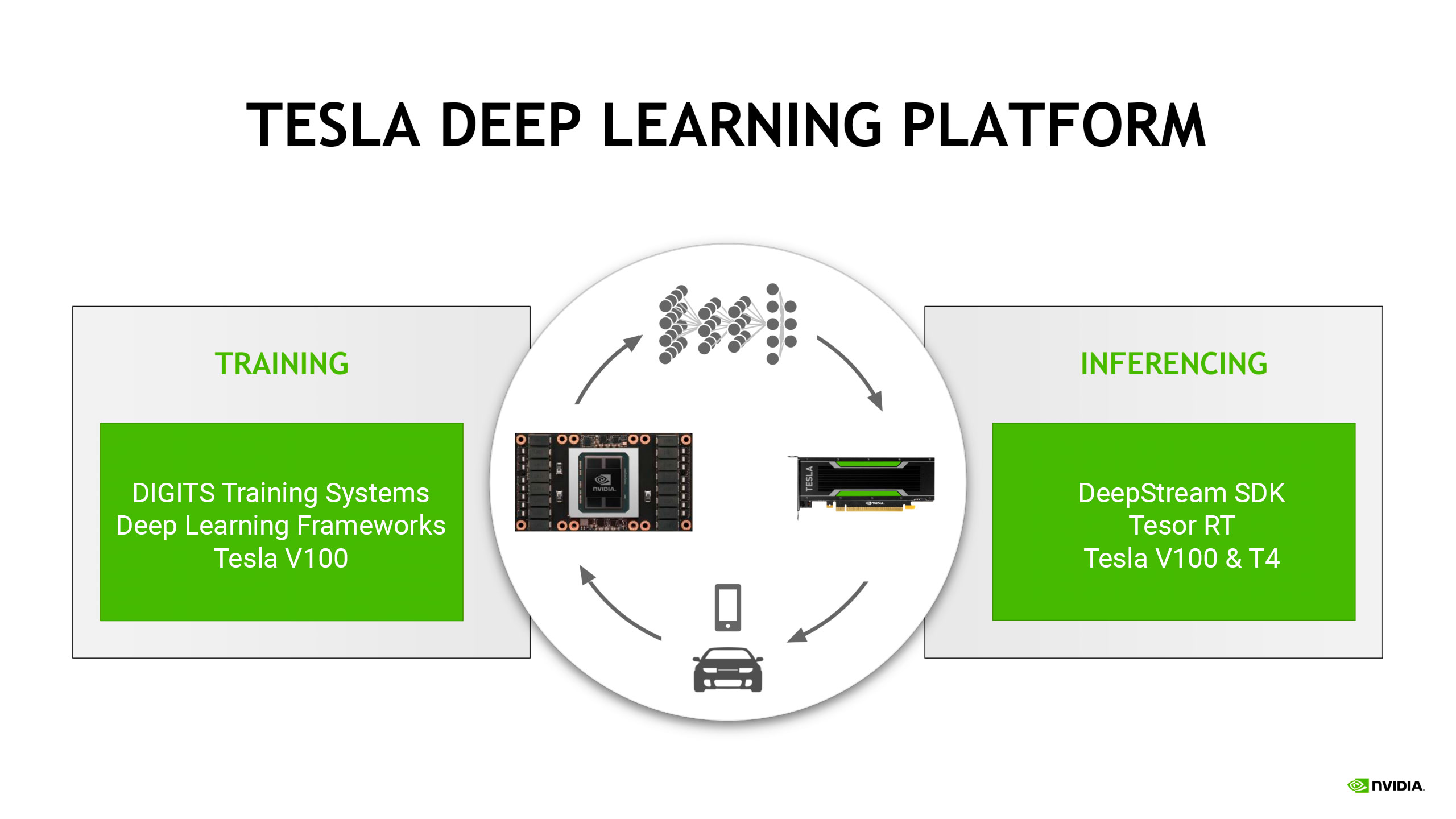

Ускорение тренировки все более сложных моделей нейросетей является залогом повышения продуктивности специалистов по обработке данных и более быстрого создания сервисов на основе искусственного интеллекта. Серверы на основе Tesla V100 используют производительность новой архитектуры NVIDIA Volta™ и сокращают время тренировки алгоритмов глубокого обучения до нескольких часов.

Суперкомпьютер FORSITE HPC-1000

Универсальный гибридный сервер для задач AI/DL/ML, позволяет установить до 4-х графических ускорителей NVIDIA.

Особенности:

- поддержка 4x NVIDIA NVIDIA A100/RTX A6000

- поддержка 2x Intel Xeon Scalable/ 2 x AMD EPYC

- поддержка до 4TB DDR4 3200MHz ECC/REG

- 1U GPU - сервер

Суперкомпьютер FORSITE HPC 4029 AI SXM NVlink

Гибридный графический сервер для решения AI/DL задач. 8 x ускорителей NVIDIA A100 объединенных высокоскоростным интерфейсом NVLINK.

Особенности:

- поддержка 8x NVIDIA NVIDIA A100-80GB SXM2

- поддержка 2x Intel Xeon Scalable / 2 x AMD EPYC

- поддержка до 8TB 3DS ECC DDR4-3200MHz

- 4U GPU - сервер

Суперкомпьютер FORSITE HPC-6049 AI

Решение высокой плотности для инференсных задач, 2х Intel Xeon Scalable с возможностью установки до 20-тиграфических ускорителей T4/A2.

Особенности:

- поддержка 20x NVIDIA TESLA T4/A2

- поддержка 2x Intel Xeon Scalable

- поддержка до 3TB DDR4 2933MHz ECC/REG

- 4U GPU - сервер

Инференс – это та задача, для выполнения которой необходимы обученные нейронные сети. Так как новые данные поступают в систему в виде изображений, речи, поисковых запросов по изображениям, именно инференс позволяет находить ответы и давать рекомендации, что лежит в основе большинства сервисов искусственного интеллекта. Сервер, оснащенный одним GPU NVIDIA, обеспечивает в 27 раз более высокую производительность в задачах инференса по сравнению с сервером на основе CPU, что приводит к значительному снижению затрат на инфраструктуру дата-центра.